在数字化转型浪潮中,企业正面临一个关键抉择:如何平衡AI应用的便捷性与数据安全性?大模型私有化部署提供了突破性解决方案——将AI能力直接嵌入本地环境,实现从基础设施到应用层的完全自主可控。这不仅是技术部署方式的改变,更是企业智能化战略的重要转折点。

① 数据安全与隐私保护:所有数据交互均在用户自有设备中完成,无需上传至任何外部服务器。这对于涉及商业机密、个人敏感信息或高保密性内容的场景尤为重要,真正实现数据不出内网。

② 长期使用成本更低:避免了云端API按调用次数或Token计费的模式。对于高频使用者而言,虽然初期硬件投入较高,但长期来看可显著降低使用成本。

③ 响应更快、延迟更低:无需依赖网络传输,推理过程全部在本地完成,大幅减少响应时间,带来近乎实时的交互体验,提升工作效率与使用流畅度。

推荐工具:【DS本地部署大师】

推荐工具:【DS本地部署大师】

当前市面上存在多种本地部署方案,例如Ollama等基于命令行的工具,在开发者圈层中较为流行。但这类工具通常要求用户具备一定的技术基础,如熟悉终端操作、环境变量配置等,对新手不够友好。

而「DS本地部署大师」则主打极简体验,专为非技术人员设计。以下对比清晰展示了两者的差异:

| 特性 | DS本地部署大师 | Ollama等命令行工具 |

|---|---|---|

| 核心特点 | 图形化操作界面,支持一键式安装与运行,全流程自动化。 | 轻量化设计,依赖命令行进行模型管理与调用。 |

| 操作难度 | 极低门槛,无需编程经验,全程鼠标点击即可完成。 | 中等以上,需掌握基本CLI指令及系统配置知识。 |

| 部署流程 | 集成模型下载、环境搭建、服务启动与对话交互于一体。 | 功能模块分离,运行模型简单,但图形界面需额外部署。 |

| 适用人群 | AI初学者、办公人员、追求便捷性的普通用户。 | 开发人员、研究人员、偏好自定义与扩展的技术用户。 |

总结来说,如果你希望在自己的Windows电脑上快速、无痛地运行DeepSeek大模型,不想被复杂的配置困扰,那么「DS本地部署大师」无疑是最佳选择。

部署流程详解

准备工作:检查硬件与获取软件

硬件要求确认:本地运行大模型对计算资源有一定需求,重点在于显卡和内存。

显卡建议:优先选用NVIDIA显卡,显存(VRAM)尤为关键。运行7B级别的模型,推荐至少8GB显存;参数规模越大,所需显存越高。

内存建议:最低16GB RAM,32GB或更高将获得更佳性能表现。

第一步:安装部署软件

第一步:安装部署软件

前往官方渠道下载「DS本地部署大师」安装包。建议将软件安装路径设为非系统盘(如D盘或E盘),以避免占用系统资源,影响整体运行效率。

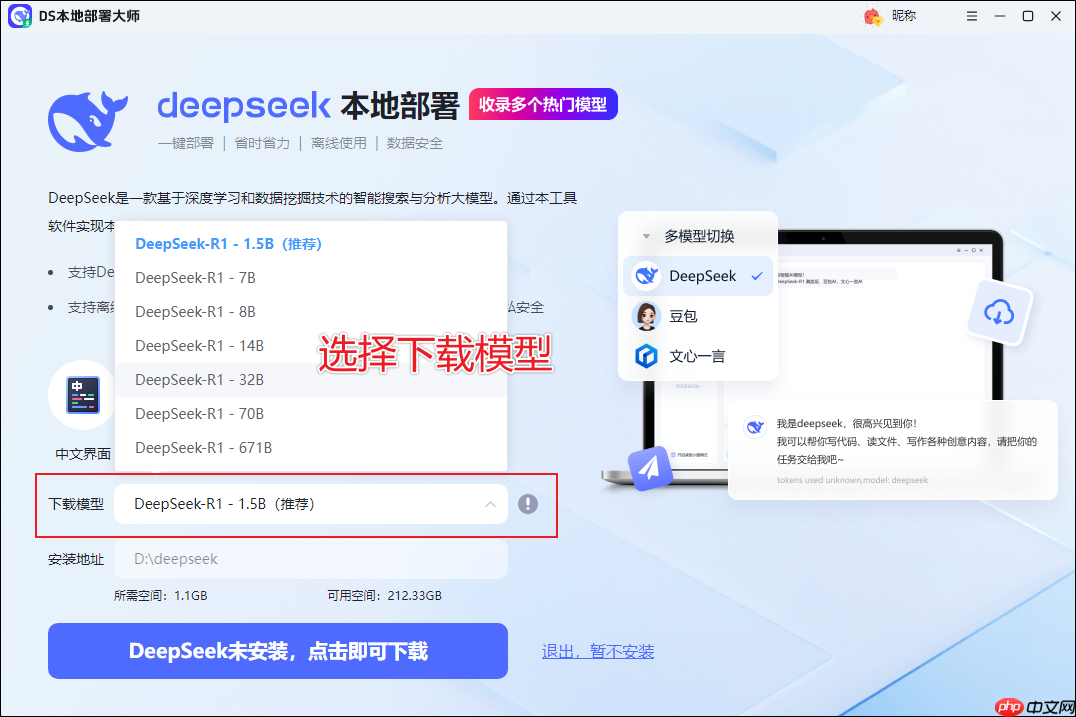

第二步:选择并下载DeepSeek模型

第二步:选择并下载DeepSeek模型

安装完成后打开软件,在主界面点击"下载模型"。你会看到清晰列出的不同版本模型。根据你的硬件条件选择合适的型号。初次尝试者建议从1.5B或7B的小型模型入手,兼顾性能与资源消耗。点击"下载"后,工具会自动完成模型获取、环境配置等全部流程,只需耐心等待即可。

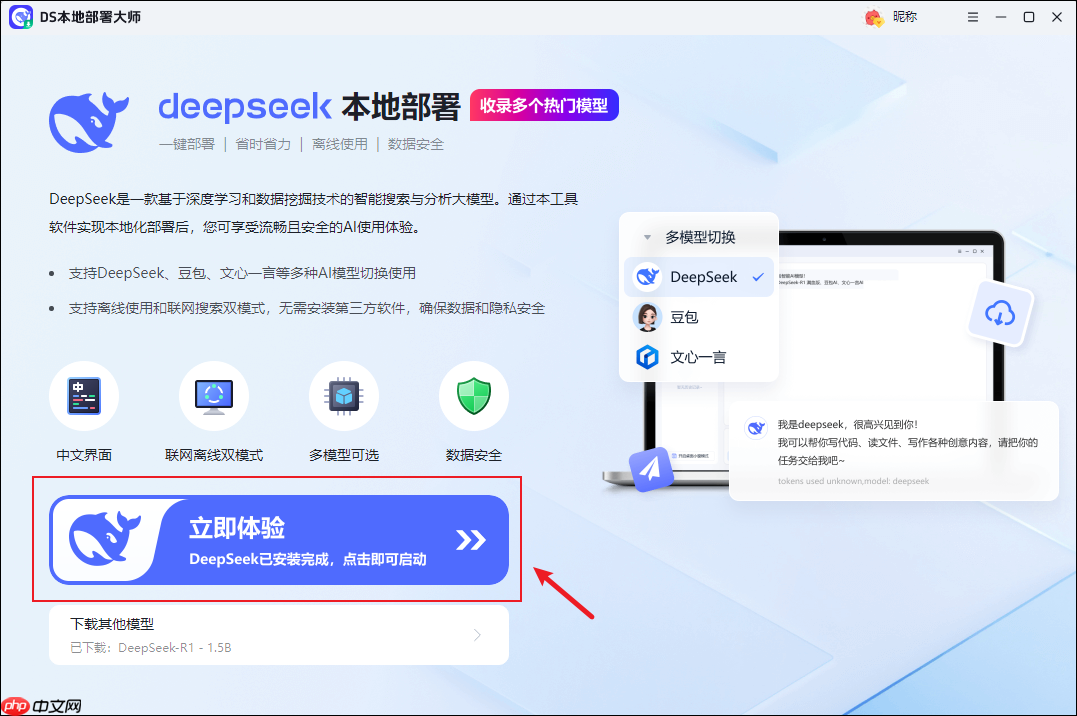

第三步:启动模型并开始对话

第三步:启动模型并开始对话

当模型成功部署后,点击"立即体验"即可进入交互界面,正式开启与本地AI的对话。

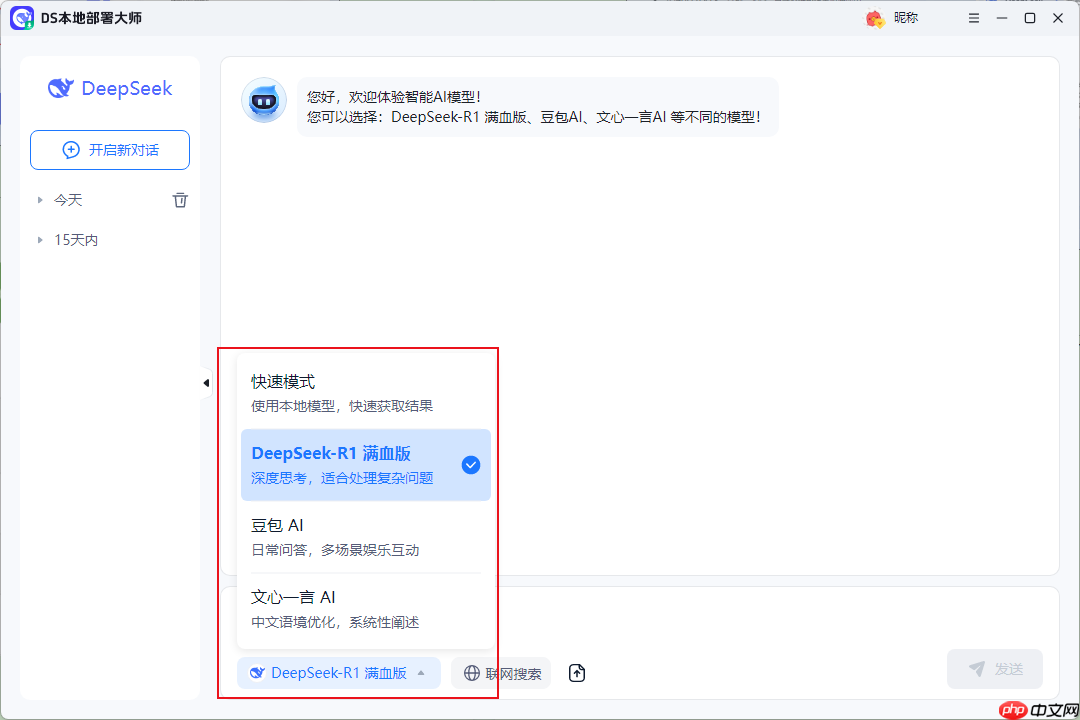

在输入框中提出问题或下达指令,即可获得由本地模型生成的回答。你能明显感受到近乎即时的响应速度,体现出本地推理的优势。提示越具体,输出结果也越精准丰富。

在输入框中提出问题或下达指令,即可获得由本地模型生成的回答。你能明显感受到近乎即时的响应速度,体现出本地推理的优势。提示越具体,输出结果也越精准丰富。

在对话界面中,除了使用本地模型外,还支持切换至多种在线模型,如DeepSeek在线版、文心一言、豆包等,并可启用联网搜索功能。

在对话界面中,除了使用本地模型外,还支持切换至多种在线模型,如DeepSeek在线版、文心一言、豆包等,并可启用联网搜索功能。

这种双模式设计极大提升了实用性:

① 涉及隐私或敏感内容时,使用本地模型,确保数据完全可控。

② 需要获取最新资讯或进行高质量创作时,切换到联网在线模型,利用其更强的知识库与更新能力。

私有化部署的价值远不止于技术实现。从战略角度看,它重构了企业数据资产的掌控方式,使AI应用与核心业务深度绑定。在金融、医疗等高度监管领域,本地部署能完美满足合规要求;对中小型企业而言,长期成本优势显著;而即时响应特性则能优化客户服务体验。

展望未来,随着边缘计算设备性能提升,本地AI将向更轻量化方向发展。模型压缩技术、硬件加速方案和分布式推理架构的进步,将使私有化部署在移动端和物联网设备上成为可能,开启智能终端的新纪元。

以上就是关于大模型私有化部署的完整解析,从核心优势到实操指南,助您构建安全高效的本地AI系统。更多前沿技术解析,请持续关注更新。